ChatGPT刚推出的时候,大家发现大模型虽好,但有两大缺点:

知识截断(Knowledge Cutoff),因为是静态知识库,必然有更新截止期。所以在大模型上查找即时信息,回答就不太灵光。我今天(2025年12月3日)还问了问ChatGPT他的知识库更新日期,说是2024年6月。

幻觉(Hallucination): 如果没找到信息、或者在知识边界外的模糊地带,模型会“一本正经地胡说八道”。

这时候,Perplexity异军突起,开启了“对话式答案引擎” (Conversational Answer Engine)。

简单来说就是三个步骤:

1.检索(Retrieval):当收到用户问题时,系统先通过传统的搜寻引擎(如 Bing、Google)爬取网络上的即时、相关资讯。

2.增强(Augmented):将检索到的最新资讯,连同用户的原始问题,一起作为上下文或参考资料喂给 LLM。

3.生成(Generation):LLM 基于这些即时、有源可溯的资料来生成回答,而不是单纯依赖其内部陈旧的训练数据。

这个模式就是RAG,原理有点复杂,我用NotebookLM生成了一个示意图。

这样,大模型不仅解决了即时性问题,更重要的是它提供了引用来源(Citations),大幅提升了答案的可信度,有效抑制了幻觉。

RAG 很快就从 Perplexity 的独门秘技变成了所有主流 LLM 的标配。

Google Gemini:作为搜寻引擎的霸主,Google 将 Gemini 与自家的搜寻能力深度整合是理所当然的。

ChatGPT:意识到知识即时性很重要之后,迅速推出了“Browse with Bing”功能,让 ChatGPT 能够联网查询最新资讯。

Microsoft Copilot:从一开始就是将 GPT 模型直接嫁接在 Bing 搜寻之上,其本质就是一个以 LLM 驱动的搜索产品。

这时候,你也许就会发现,营销人的主要优化对象不是大模型的静态知识库(更新一次需要等待的时间太久了),还是互联网上的即时信息。

有了信息综合用户的问题后,大模型根据上下文“思考”、“推理”,生成答案。

过去是用户是输入关键词后再一个个打开蓝色链接中挑选解决方案,现在机器会帮你选好,直接给出答案。

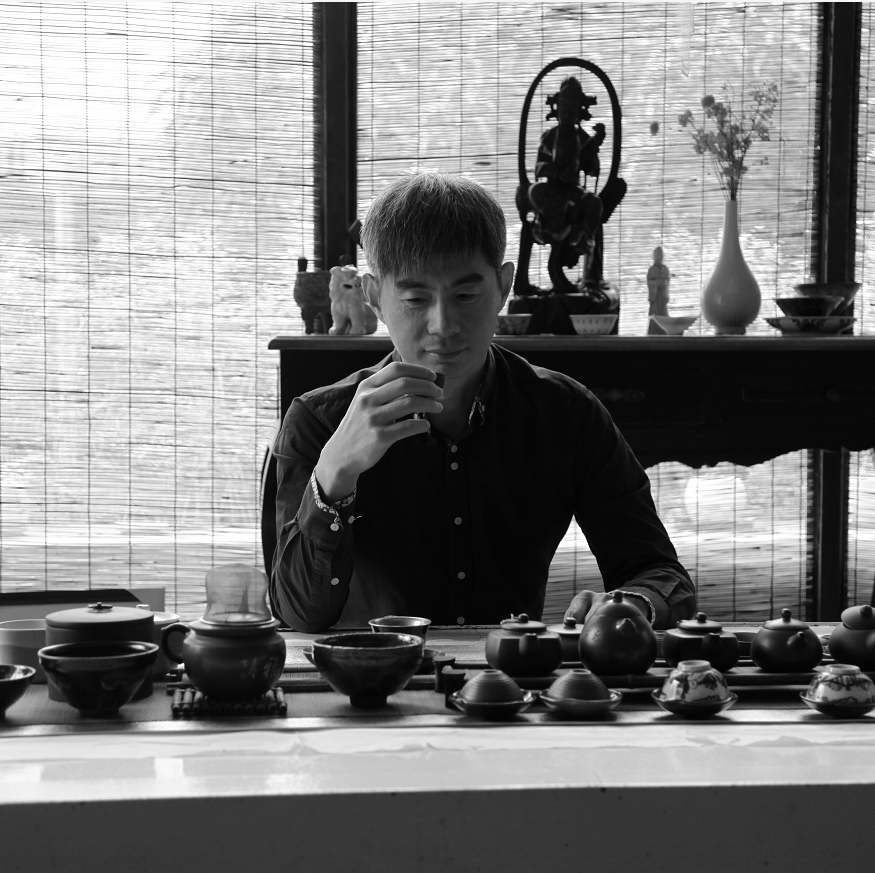

不过,大模型也是“爱惜自己的羽毛”的,毕竟搞砸了,用户就跑了。

所以,GEO并不是要彻底与SEO决裂,而是在内容上要求更高。

它喜欢具体、权威、结构性强的内容,所以你会发现所有的GEO文章都在强调以下tips:

1、内容深度与权威性强化

深度而非广度,专注于特定主题,提供深入的分析、数据和见解,而不是浅尝辄止。

引用自身,在相关文章中互相链接(强大的内链结构),向 RAG 系统展示您对某个主题拥有全面的知识体系。

2、增加可信度

明确作者身份(比如简介、资历和专业背景)、第三方权威机构背书等。所有引用的数据、图表或统计数字都必须明确标注原始来源,以便 AI 进行事实核查。

3、 结构化数据标记

使用 Schema.org 标记来明确内容类型(如 Q&A、HowTo、FactCheck、Article)。例如,使用 FAQPage 标记总结常见问题的回答,而不是一篇长文。

4. 清晰的标题和段落结构

将信息分解为独立的、自包含的段落。每个段落应专注于一个论点或一个事实。同时使用列表和表格来呈现数据和关键信息,而不是图片。

这4点其实我也写过很多次,当你理解大模型是如何给我们答案的时候,也许就知道为什么需要这样优化内容了。

依我看,现在GEO 对内容要求更严谨、更负责。

你的竞争对手是那些力争被 AI 信任的内容源,被用户信任、被机器信任,才是未来内容营销的关键。

小程序

扫码打开微信小程序

小程序

扫码打开微信小程序

APP下载

扫码下载市场部网 App

APP下载

扫码下载市场部网 App